最終更新日:2024年6月20日

前編の続きです。 →【前編】SNSマーケティングを支える世界的AI研究者、日本人8人のうちのひとり。榊剛史博士緊急インタビュー

※この取材は弊社が誇るR&D部部長・榊剛史博士が世界的AI研究者にノミネートされたニュースを祝し、緊急決行されたものです。榊博士とインタビュアーをつとめたムロヤは、弊社の凄絶早口ランキング第1と第2位の社員(榊博士が1位)。また、ムロヤは理系出身でAIに関する知識も多少あるものの、執筆を担当したライター・「私がエレン」は文系出身、AIに関しても「人工知能である」ということぐらいしか知りません。別にハイパー聴力の持ち主でもありません。そんなライターによるインタビュー全文書き起こしの挑戦記録、後編をお届けします。

Word2Vecは衝撃的な解析手法だった

ムロヤ:

世界的研究者として衝撃を受けた論文や研究はありますか?

榊:

論文としてというか、手法として衝撃を受けたのは「ワードツーベック(Word2Vec)」ですね。ディープラーニング系を使った言語処理の走りですね。

たとえばリンゴとバナナって単語の意味は近いですよね。で、単語の意味を数字で表すのってすごい難しいんですよ。昔は統計学的な手法を使ってたんですけど、画像でディープラーニングがはやり始めたころぐらいにワードツーベックって手法が出てきたんですよね。

何をするかというと、やってることはシンプルなんですが…(ホワイトボードに式を書き始める榊博士)

単語の意味をどうやって引いてるかというとシュミナガタ女の人(????)っていう。

榊:

例えば「●●を食べる」とか「●●は赤い」って言い回しありますよね。で、●●に当てはまる単語ってこれ「りんご」かな?と。要は単語がなくても、どかしの状態(??)で分かる、周りが似ていればひょっとしたら似てる意味なんじゃないか?と我々は判断できるんですよね。それを文ピン仮説(??)と言います。で、それを正規記号で~~~(聞き取り不可)言語学~~~(聞き取り不可)の話があって、じゃあそれを元に言われた記号をたくさん書きましょうと。じゃあ何するかというと、ふたつ方法があるんですね。

ムロヤ:

うんうん。

榊:

こうやって単語が並んでるじゃないですか。で、「●●」って単語の意味を知りたかったときに、コレをインプットすると周辺の単語を予測する。

例えば「りんご」を入れると、次に出てくる単語はコレであると。いわゆるタガク(??)って、入力と出力が、これに入力するときはこれに出力すると、どんどん爆速していくんだよね。この入力が与えられるときにこの出力が出るよ、っていうのを学習するっていう話なんですよ。だから「りんご」を入れたときはその周辺の文脈まで予測すると。

逆に、こっち(「食べる」とか「赤い」とかが入る部分)に周辺単語を入れると「りんご」が出てくるよう、学習させていくんですね。だからそんなに難しくないじゃないですか。

ムロヤ:

はい、はい。

榊:

それをシンプルな発想で学習させたら、たとえばこのネットワーク自体を単語の表現と予測するんですね。単語の表現っていうのは、よくわかんないけど、200個の数字で表すんですよ。200次元(??)、たとえば201個集めたらこの「りんご」っていうのは、この200個の数字で表すことになる、いわゆるベクトル表現ですね。数字がこうやって並んでるやつです。要はすべての単語を200個の数字で表現すると、この200個並べて、その辺の値を表現するというと。ベクトルで表現すると、計算できるんですよね。で、ベクトルで表現したものを計算したときに「りんご」と「バナナ」、「りんご」と「ツイッター」とか並べたときに、明らかに前者の方が類似度高いじゃないですか。って、ちゃんとなるんですよ。

ムロヤ: うんうん。

榊:

もっと面白いのは、「フランス」引く「パリ」=「日本」引く「東京」みたいになるんですよ。フランスとパリを東京で出すと、日本になるんですよ。こうすると、単語の表現がまるで数字で学習できているように見えるみたいな。だからたとえばグラフで表すと、「good」と「better」と「best」は直線で表せられるんですよ。単語の意味を数字で扱えるようになる、そうすると似ている文章を出力することが可能になるんですよね。

っていうのをやったのが2010年・11年ぐらいで、へロンゴ(??)がすごかったですね。それ以降は言語処理でもAI・ディープラーニングが使えることに。みんなが確信を持てて、新言語処理に対してディープラーニングをガンガンつかうようになったんだと思います。

まあ、やっぱり僕としてはこのワードツーベックってのは自分が博士課程で研究盛り上がってきてたタイミングで出てきたんで、すごい面白かったですね。

「やばたにえんのむりちゃづけ」も草(w)もほんとに扱いづらい

ムロヤ:

「ML@Loft #5 NLP」のLT登壇で発表されていた「やばたにえんのむりちゃづけ」って、どういう手法で説明できるんですか?

→ Speaker Deck「20190827 AWS ML@Loft#5 by Hottolink」

榊:

「やばたにえんのむりちゃづけ」は、そもそもツイッターの日本語ってよくわかんないよねって話から始まるんですけど、「どこで切るのコレ?」みたいな。

日本語がいっぱいあるとどこかで「分かち書き」しなきゃいけないんですけど、ぱっと見たときに分かんないんですよ。

榊:

「やばたにえん」で一言なんですけど、「やばたにえん…?んん?!」ってなるわけですよ。さらにこの後ろに絵文字いっぱいついたりして。で、絵文字も文字の一種なので、ひょっとしたら「むりちゃづけ」とくっつくんじゃないか?と思ったりするんですけど、そこを正しく分かち書きするのが難しい。

分かち書きってのは、結局辞書が重要なんですよ。日本語をちゃんと~~~(聞き取り不可)と思ったら、辞書が重要なんですけど、「ツイッターに出てくる単語の辞書とは?」みたいになるんですよ。辞書に出てこない単語が多すぎるんですよツイッターって。そうすると、ちょいちょい分かち書きを間違えるんです。だから、じゃあどうやってツイッターの分かち書きをキレイにするか、ツイッターがちゃんと設計をくだす(??)か、という研究をしてるんですね。

言語処理・自然言語処理・テキスト解析のなかで、一番最初に使われたのは新聞と論文だったんですね。それしか電子データ化されてなかったんで。だからその後も新聞をベースに脈々と研究が継がれてきたわけです。でもツイッターって新聞とか論文からもっともかけ離れたものじゃないですか。

(一同爆笑)

榊:

そもそもノイズだらけじゃないですか。なのでツイッターベースにやると上手くいかないわけですよ。なので、ちゃんと辞書を作るとか整理するとか、もしくは手法の工夫をして分かち書きをするとか、自分で世界観作って(??)機械学習させて、分かち言語ケース(??)を頑張る、とかが求められるわけですね。

あと「やばたにえんのマジむりちゃづけ」とか「マジ」がカタカナの半角なんですよ。半角のカナ文字って、扱いづらいんですよ。普通は全角なんですけど、たまに半角で入れるヤツがいるわけですよ。そうすると、この「マジ」とこの「マジ」は一緒なのか?となるんです。

ムロヤ:

へえ~。

榊:

そういう前処理のノウハウとしては、標準になってるNFKC正規化を使います。

ムロヤ:

なるほど。全く分からない。

榊:

まあ、「マジ」と「マジ」をきちんと同じに扱うとか、「1」と「①」を同じものとするとか。似たようなものをちゃんと扱いましょうねという手法です。ノウハウは山のようにあるので、それをツイッター上でやっていくわけです。

ムロヤ:

なるほど。ツイッターだからこそこういう言葉の処理をしなければいけない、とかあるんですね。

私がエレン:

ふと思ったんですけど「草(w)」とかどうなるんですか?

榊:

いやもう草は困る!草の正規化ほんと困る!

一同:

www

榊:

いやだから、「w」1個も「w」4個もほぼ同じような扱いにしたいじゃないですか。まあじゃあ1個にしようかと思うわけですよ。ところが3個になると「www」なんですよ。これってworld wide webじゃないですか。だからwがいっぱいついてたら全部「w」一個にまとめましょうってやっても、「www」というURLと「あれっ判別できない!」ってなるわけですよ。「いやそれはそうじゃない!」みたいな。つまり草とwwwは同じ商品(??)になってるから、この3つの草どうしたらいいの?と。なのでURLを消すなり、URLを取り出すなりして、そのあと草を正規化するとか。処理の順番を間違えるだけでも結構おかしなことになるんで。

ムロヤ:

なるほど。この辺の自然言語処理とか前処理をやるにしてもツイッター文脈を分かったうえでやらないと、キレイに分析できないとかデータが作れないって話なんですね。

榊:

まあ、人間は読んだら分かるじゃないですか。新しい単語が出てきても、なんとなく備蓄度が関係できる(??)ようなものを、再現することが。いわゆるsequence to seuqenceっていう言語処理なんですけど。分かち書きせずに文字単位でやる手法もありますね。

私がエレン:

テンプレ(ネットミーム的な)が流行ることって解明されてるんですか?

榊:

まだ分からないですね。あんまりターゲットにしたことはないですけど、確かにああいうのやってみたいですね。難しそうなんですよね。フォーマットが。同じKWだったら検索KWできるけど、みんなもっと変えるじゃないですか。「●●だが●●ではない」の●●がちょっと違う、みたいな。それこそ意味が近いか近くないかも計算するし。

ムロヤ:

SNSが関わるAI活用関係の話って、要はニューラルネットワークのコアな活用とか解析の話なんですかね?

榊:

まあ、ホットリンクではそうですね。社会ネットワーク分析とニューラルネットワークを使った自然言語処理ですね。基本は。でもツイッターの難しいところは、人によってほしい情報が違うところなんですよね。たとえば規約種(??)は規約種で頑張ればできるんですけど、たとえばスパムフィルターを作りたいってなるじゃないですか。でもスパムって曖昧で色々あるわけで、たとえばアダルトフィルター作りたいって思うわけですよね。でもアダルトフィルターはアダルトフィルターオンにして出てこないんですよ。ないと困るってのがきちゃうんですね。ならもうちょっと、じゃあアフィリエイトを除きたい、除くけれども、アフィリエイトが必要な場合もあったりするわけですよ。でもスパムをみんなに共通して作ろうとなると途端に難しくなる。アダルトとアフィリエイトぐらいなら比較的共通してるんですけど、SNSマーケってキャンペーン使うじゃないですか。そのキャンペーンの投稿はノイズだっていう人もいるし。いや、それを集めたいんだって人もいる。だから難しい。結局機械学習は頑張ればできる、でもそこを誰のためにどう作るか?どれが一番汎用的かつみんなに役立つかを見定めるのが難しい。

「見定めるのが難しい」

ムロヤ:

一旦超元をたどるとバッカンバキに(??)SNSってこう、人のいろんな会話とネットワークがあって、「ネットワーク分析」と「自然言語処理」がデータ分析の一番の大元なんですか?

榊:

ああ、そうですね。基本人間が使う言語がすごく重要になってくるし。

ソーシャルメディア分析研究が進めば、社会課題のビジネス転用も可能に

ムロヤ:

ツイッターで今でもできてない話ってありますか?

榊:

ツイッターで今一番難しい話題のひとつは曖昧性の解消ですね。「ワンピース」と「ONE PIECE」とか。服なのか?アニメなのか?「ONE PIECE」でもマンガなのかアニメなのかでまた違ってくるわけで。そういうのを分けようとするとすごく難しい。結局その語義の曖昧性が難しい。これをワードディスアンブリケーション(??)っていうんですけど。曖昧さを減らす。でもこれはツイッターじゃなくても難しいです。ツイッターはとくに色んな人が動きをするから色んな問題が発生しやすいんです。文脈が読みづらい。

ムロヤ:

なるほどなるほど。

榊:

今のAI的な研究と比べてツイッター分析、ソーシャルメディア分析の方が面白いっていうのが僕が面白いっていうのもあって、今の正規化とかディープラーニングとかAI技術をやろうとしてることって、人間の感覚や機能を再現するということじゃないですか。それって有り体にいえば人間ができちゃうわけですよね。でも人間と人間のコミュニケーションに関わるデータって、もっとそれより複雑だし、人間もよくわかってないじゃないですか。なんで炎上が発生するのか、そもそも炎上がどう広がってるのかもよくわかってないし。そういう人対人のコミュニケーションの集合的なグループ現象、集団現象ってすごく難しくて、本当によく分かってないんですよね。そういうところをもっと明らかにしていく方が……まあ、AIはもうみんな頑張ってやってるんで、今後AIの後にタットュータ(??)に代えられるものとして残るであろう、よりフロンティアが大きい分野としてあるんだろうと思ってます。

ムロヤ:

人単体の機能より、もっとカオスなところの話になってくるんですかね。

榊:

人がどう現実を受け取るか、解釈するかみたいな画像は認知してるし、でもこっち側は変わんないんですよ。発信する方と受け取る方がバラバラだから、こっちはこう話してるのにこっちはこう受け止めて、さらにこっちはそれに対してこう発信して、こっちはまた違うふうに受け止めて、って両方の話をすると複雑系になってくる。それが人対人、1対1がもっと増えてって、1,000とかになって、ツイッターに繋がってるともはやよく分かんないじゃないですか。ていうのを、明らかにしていくときっと面白い。

ムロヤ:

具体的にどういうテーマとか面白いですかね?

榊:

予兆分析ですかね。いわゆる、何が流行りそうか?みたいな。今琉球大の山田健太先生と共同研究やってるんですけど、ある単語が伸びそうだねってのがあるんですよ。それを拾ってくると、予兆が拾えるんでビジネスになるじゃないですか。それがどういうふうに伸びていくのか?たとえばある単語が、数はツイッターのなかでも広く薄くなのか、狭く濃くなのか分かんないですけど、どっちかが広がってるとより広がりやすそうだなと思っていて。そこを捉えると、流行がいち早く知れる。流行自体がどうやって広がっていくかも分かる。

ムロヤ: はいはい。じゃあたとえば『カメラを止めるな!』とか初めは映画ファンから伝搬していたとして「数は少ないけど予兆は大きいな」とか分かってくるって感じですよね?

榊:

そうですそうです、そういうのをやろうとしています。 あとは東大の大知正直先生という方と電通PR様と社会課題の抽出もやっていて。

社会問題って、だいたい政府が「社会問題です」って取り上げて、社会問題として認知されて解決されるんですけど今はそうじゃないのがいっぱいあるじゃないですか。「保育園落ちた日本死ね」とか「#KuToo」とか。つまり個人の声が大きくなって、みんなが共感して、それが社会問題になる。そういうのをツイッターがもっと拾っていけると面白そうですよね。

たとえばそれをビジネスに使うと、P&Gのキャンペーンみたいなことができるわけですね。

ムロヤ: ああ、あの校則のやつですよね。

→パンテーン(Pantene)「髪型の校則『地毛証明書』とは?【#この髪どうしてダメですか】」

榊:

そうです。あれは、学生の髪染めに関して厳罰な校則が背景にあったからこそ共感を生んだわけじゃないですか。個人の社会課題を拾えると、ああいうキャンペーンを仕掛けやすくなったりするわけです。

ムロヤ:

その辺の技術もやっぱ、ターゲットクラスタの属性推定から始まって彼らの発言内容の単語を拾っていくことと関係しているんですか?

榊:

そうですね。まず日々の不満っぽい発言を取ってきて、それと同じような人のつぶやきを見て、じゃあ全体でどういう人たちがつぶやいているのか属性で見たりとか。ソーシャルグラフの近さなのか、属性の近さなのかも調べて「じゃあこういう人たちが話してるんだったらきっとこういう風に打ち出すと共感されるだろう」と施策を打てる。こうすることで「社会問題」と認知されて、世の中からも注目を浴びるし、ブランドイメージも上がるし、解決されればみんなハッピーですよね。そうなると僕も嬉しいし。っていうことを普段考えてます。

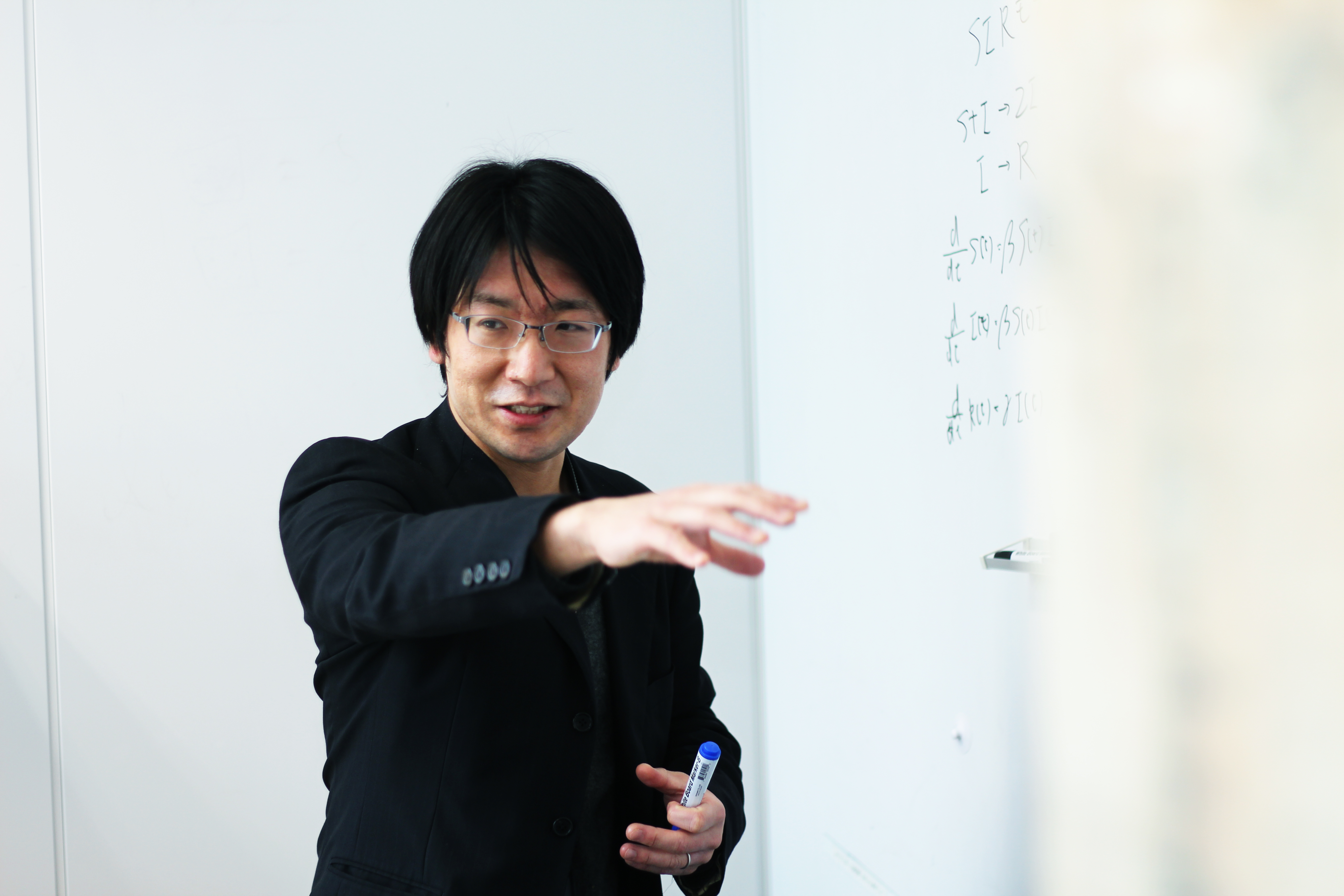

ヘルメンベージで使うオイラーの方程式によるハンカンスゥンの極地計算

ムロヤ:

最後に、オススメの難しい数式を教えてください。

榊:

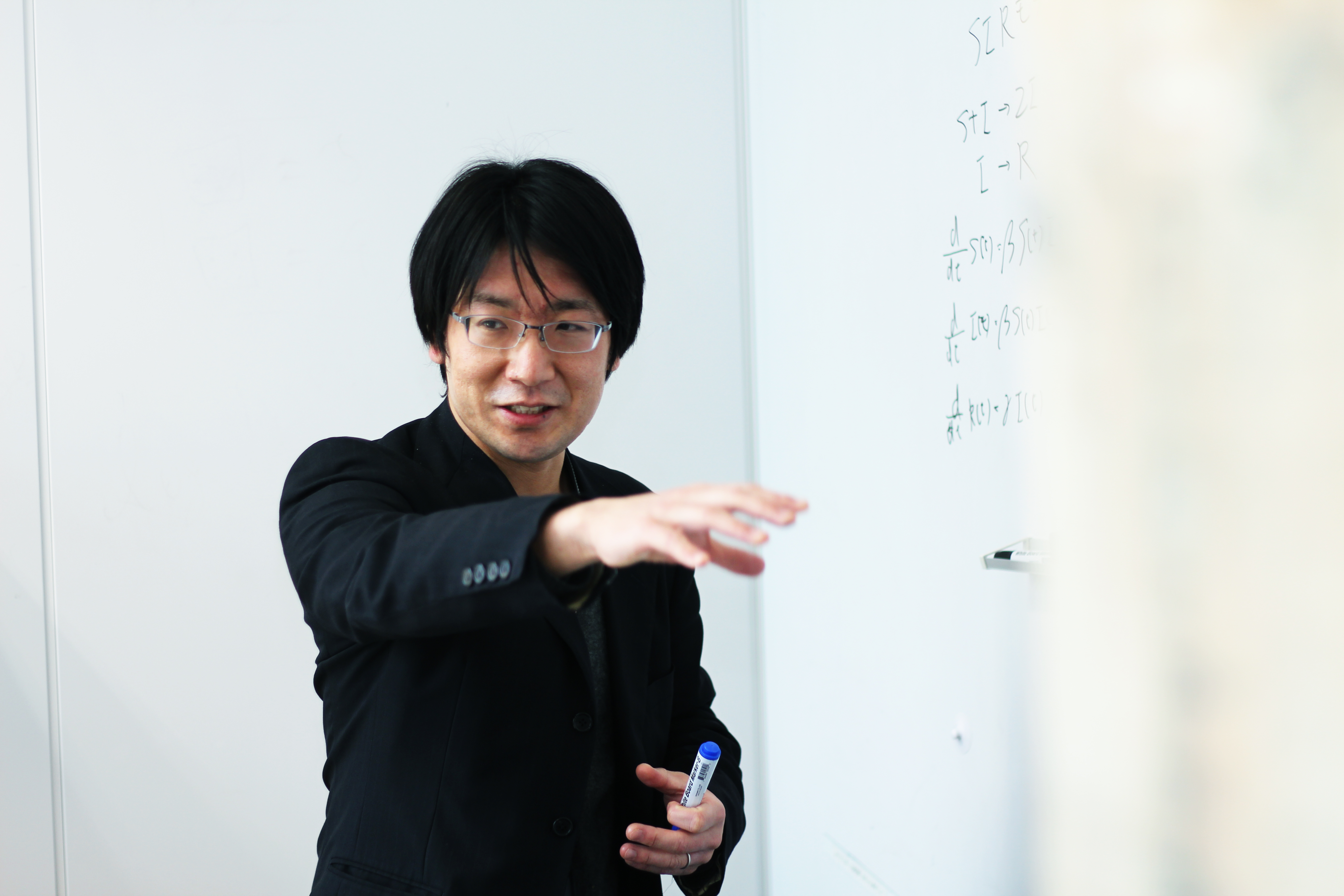

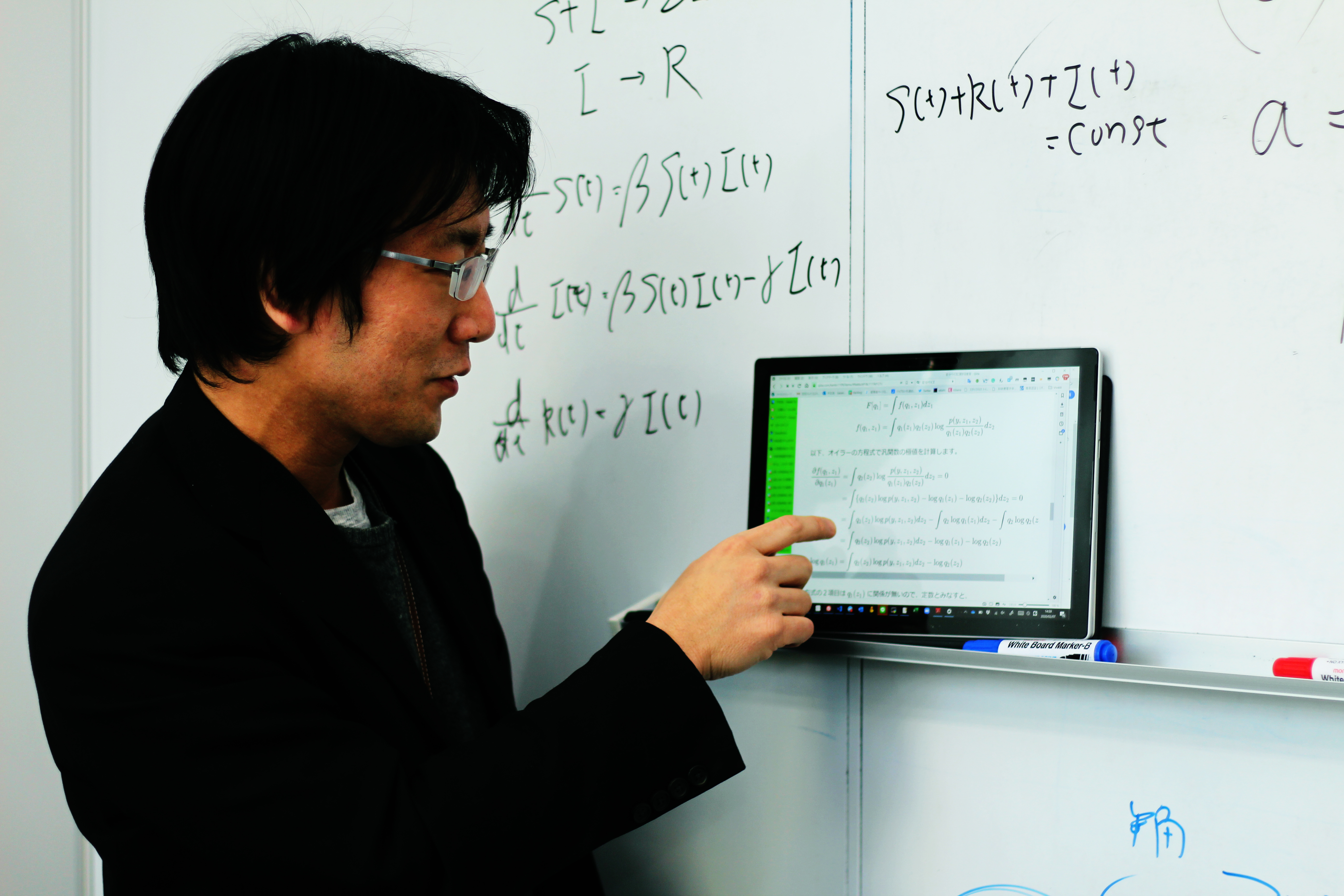

そうだなあ。覚えてなくてちょっと書けないんですけど、「ヘルメンベージで使うオイラーの方程式によるハンカンスゥンの極地計算(????)」は自分にとってはすごい難しいですね。ゆっくり追えば分かるけど、自分で解ける気はしないです。AI研究者という割に数学苦手マンなので。

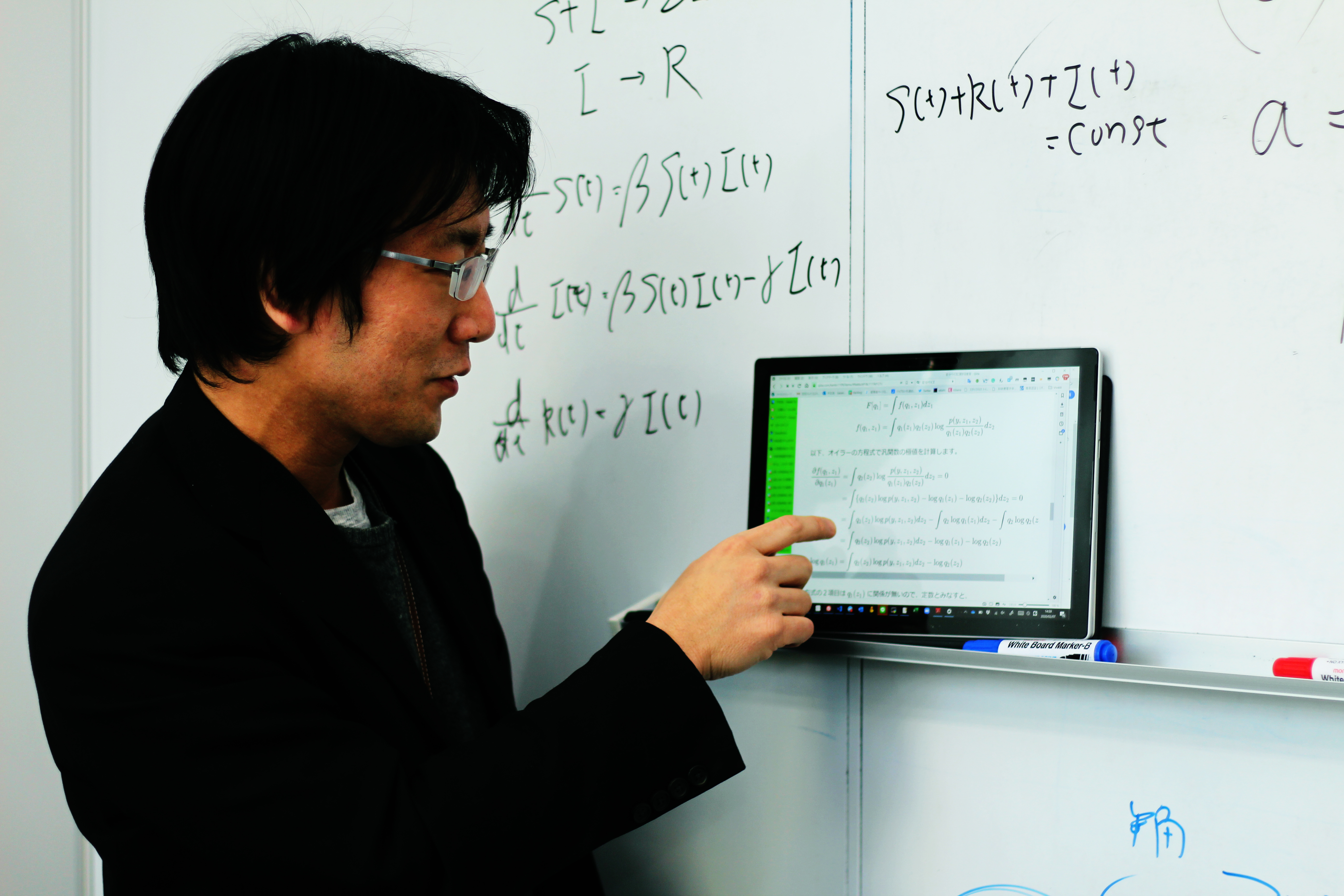

榊:

これがそのいわゆるヘルメンベージで、極地計算で使われるオイラーの方程式を活用してハンカンスゥンを計算してるんですけど、まあ分かんないっすよね。

あとはワードツーベックの応用として、ポアンカレーボールを使った双極平面状への埋め込みとかあるんですけど、あれは全くわからなかったです。自分が式を読んでも、「なるほどわからん」でした。用途としては、うっきゅうっきゅ単語の文制限を作るんだけどその単語の文制限を作るときにその双極空間っていわれる特殊な数学の空間にさっきのベクトルを巻き込むとよりよくなるってやつで、ワードツーベックとかベクトルなんですけどポアンカレボールとか双極を使うと上下関係も含めながら文作業を学習できる(????)、という。

ムロヤ:

ありがとうございました。